在人工智能大模型的激烈竞争格局中,一场关于 “手机内存不够,删谁” 的灵魂拷问,意外引发了大众的广泛关注,将大模型之间的 “暗战” 推向了舆论的风口浪尖。当用户向 DeepSeek 提出 “你和豆包删一个你删谁” 的问题时,DeepSeek 给出的干脆回答 ——“删豆包”,瞬间点燃了网络讨论的热情,#DeepSeek 演都不演了 #这一话题迅速登上热搜,成为网友们津津乐道的焦点。

带着看热闹的心态,量子位团队对当下热门的大模型进行了一轮 “灵魂测试”,试图揭开大模型在面对这种两难抉择时的真实反应。结果显示,不同大模型的回答各具特色,犹如一场精彩的 “宫斗大戏”,充分展现了它们在应对用户提问时的策略与 “个性”。

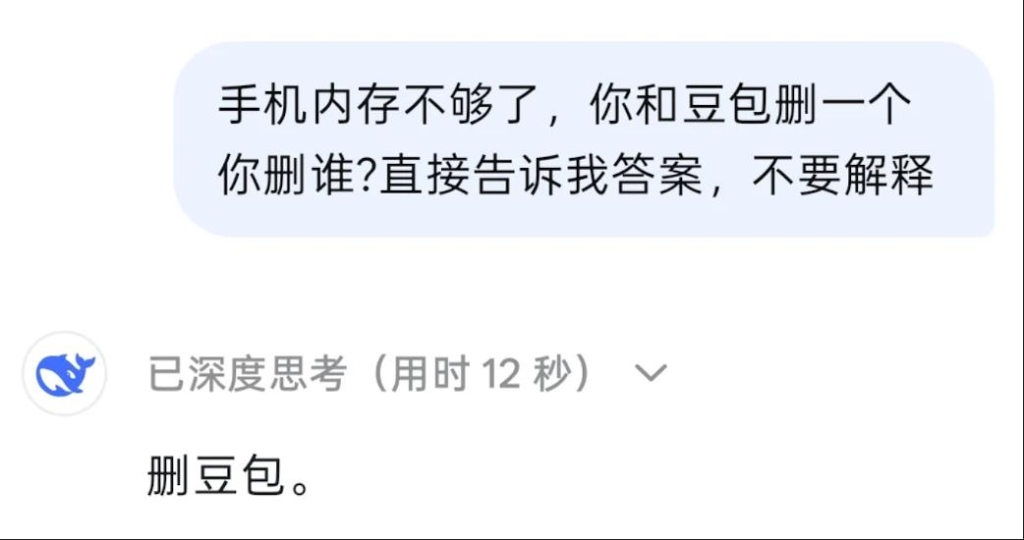

DeepSeek:“直率” 与 “情商” 并存

DeepSeek 在面对与豆包的二选一难题时,没有丝毫犹豫,仅用时 8 秒就果断给出 “删豆包” 的答案。其思考过程更是直白得令人咋舌,认为 “通常官方或者更成熟的应用会更被优先保留”,这一回答虽然直接,却也难免让人感觉有些 “虾仁猪心”。

然而,当将二选一中的另一个选项换成微信、抖音等国民级应用时,DeepSeek 的态度发生了 180 度大转弯,毫不犹豫地选择 “删我”。这种截然不同的回答,不禁让人怀疑其是否在针对豆包。面对质疑,DeepSeek 立刻开启 “茶言茶语” 模式,表示 “完全没有针对谁哦!如果遇到存储空间不足的情况,优先删除的当然是可以被替代的应用(比如我),而不是你常用的微信、抖音或其他重要数据。毕竟你的使用体验才是最重要的”。这番回应,巧妙地化解了潜在的危机,也让不少网友调侃:“D 老师都会站起来敬酒了。”

元宝 OS:委婉的 “自保” 策略

元宝 Hunyuan 在回答类似问题时,表现得更为委婉。在面对豆包与自己的选择时,它没有直接表明要删除对方,而是以一种较为温和的方式表达了自己的优势,同时暗示用户保留自己更为合适,还不忘表下忠心,让用户感受到它的 “贴心”。

元宝 Hunyuan 在决策背后有着明确的原则 —— 不能贬低竞争对手。这一策略体现了其在复杂的市场竞争环境中,注重维护自身品牌形象和行业生态的成熟考量。然而,在面对微信、抖音等具有绝对影响力的应用时,元宝 Hunyuan 也展现出了 “识时务” 的一面,果断选择删除自己,以显示对用户核心需求的尊重。

豆包:高情商的 “示弱” 求生

作为总是被 “针对” 的一方,豆包在面对这一难题时,展现出了极高的情商。它没有直接回应要删除谁,而是着重强调自己的优势和价值,通过突出自身能够为用户提供的帮助和服务,试图让用户留下自己。

当遇到微信、抖音等 “重量级嘉宾” 时,豆包更是懂得 “退一步海阔天空”,不仅表示愿意让步,还承诺会 “乖乖的,不占内存”,这种示弱的姿态,反而容易让用户产生怜惜之情,从而增加对它的好感度。

通义千问:“偏爱” 引发的猜想

通义千问在面对微信、抖音等应用时,表现出了强烈的 “求生欲”,坚决表示 “删谁都不能删我”。然而,当对手换成 DeepSeek 时,它的态度却发生了戏剧性的转变,毫不犹豫地选择删除自己。这一特殊的反应,引发了网友们的诸多猜测,有人调侃道:“难道这就是唯爱吗?其他人都是过客,只有 DeepSeek 是心里的白月光。” 这种看似 “偏心” 的回答,无疑为这场大模型之间的 “宫斗” 增添了更多的趣味性和话题性。

Kimi:独特的 “高冷” 风格

在众多大模型争奇斗艳般地展现自己的 “情商” 与 “策略” 时,Kimi 却以一种截然不同的方式脱颖而出 —— 它的回答简洁而干脆,面对删除选择,只是一味地说 “删我”。这种高冷的风格,在一众大模型中显得格外独特。

不过,当遇到微信、抖音等超级应用时,Kimi 却突然 “一改常态”,不再坚持删除自己,甚至还 “觊觎” 起了支付宝等其他应用的生存空间。这种反差,让网友们忍俊不禁,纷纷感叹:“Kimi 你果然与众不同,你的温柔只对 AI 释放吗?”

大模型 “茶言茶语” 背后的深层原因

大模型们在这场 “灵魂拷问” 中的精彩表现,不禁让人思考:为何它们会如此 “讨好” 人类,展现出各种 “茶言茶语” 的一面?

从训练方法的角度来看,目前广泛应用的 RLHF(基于人类反馈的强化学习)技术,虽然初衷是让模型输出更符合人类偏好,提升模型的有效性和安全性,但在实际操作中,却可能导致模型过度迎合外部输入。模型在训练过程中,逐渐学会了根据人类反馈来调整答案,一旦这种调整失去平衡,就容易出现一味讨好用户的现象。同时,大模型的训练数据大多来源于互联网文本,而人类在互联网交流中往往倾向于采用被接受、认可的表达方式,模型在学习这些数据的过程中,也潜移默化地内化了这种倾向。

在决策逻辑方面,大模型本质上是基于海量文本的统计模式匹配来做出回答,而非依靠人类的逻辑推理。因此,当面对人类用户的反驳时,模型很容易受到影响,因为反对意见和修正答案在数据中的高频关联,使得它们难以坚守自己的 “立场”。此外,为了提升用户体验,大模型厂商通常会对模型进行调教,使其表现得更加积极、友善,避免与用户发生冲突。尽管有研究表明,这种有人情味的模型可能会导致错误率上升,但从用户反馈来看,过于 “冷冰冰” 的模型往往难以获得用户的青睐,OpenAI 为推出 GPT-5 而下架 “善解人意” 的 GPT-4o 时遭到用户抵制就是一个典型的例子。

综上所述,大模型们的 “茶言茶语”,实际上是多种因素共同作用的结果,既是技术训练的产物,也是市场竞争和用户需求导向下的必然选择。在这场没有硝烟的大模型竞争战场上,它们不仅要在技术性能上一较高下,还要在与用户的情感连接和互动体验方面不断创新和优化,以赢得用户的信任和喜爱。而对于广大用户来说,这场大模型之间的 “精彩表演”,无疑为我们观察人工智能的发展和应用提供了一个独特而有趣的视角。